Wenn Opt-out keine echte Wahl mehr ist

Freiheit sichern in der algorithmischen Ökonomie – eine Regulierungsvorschlag von Joel Christoph.

Die digitale Ordnung beruht auf der stillen Annahme, dass wir im Zweifel einfach gehen können. In immer mehr Lebensbereichen stimmt das nicht mehr. Wenn Opt-out faktisch zur Selbstbenachteiligung wird, muss Politik Freiheit nicht nur versprechen, sondern als funktionierende Infrastruktur sichern: durch echte Wechselmöglichkeiten, durch Pflichten für Betreiber hochwirksamer Systeme und durch internationale Koordination dort, wo Märkte und Datenflüsse längst grenzenlos sind.

Das Problem

Dass digitale Dienste nützlich sind, ist kein Skandal. Ein Freiheitsproblem entsteht dort, wo algorithmische Systeme zur Voraussetzung gesellschaftlicher Teilhabe werden und sich die scheinbar freiwillige Nutzung in strukturelle Abhängigkeit verwandelt.

Ein Beispiel. Maria, 42, Architektin in München, möchte WhatsApp verlassen. Sie hat Bedenken wegen der Datenweitergabe an Meta. Sie lädt Signal herunter und bittet ihre Familie umzusteigen. Ihre Mutter winkt ab. Die Schule ihrer Kinder koordiniert Elternabende über WhatsApp. Ihr Tennisclub teilt Spielpläne dort. Ihre Handwerker-Kontakte sind nur über WhatsApp erreichbar. Maria kann theoretisch gehen. Praktisch bedeutet es, dass sie den Elternabend verpasst, nicht weiß, wann sie Tennis spielen soll, und den Elektriker nicht mehr erreicht. Opt-out existiert, aber nur als Selbstbestrafung.

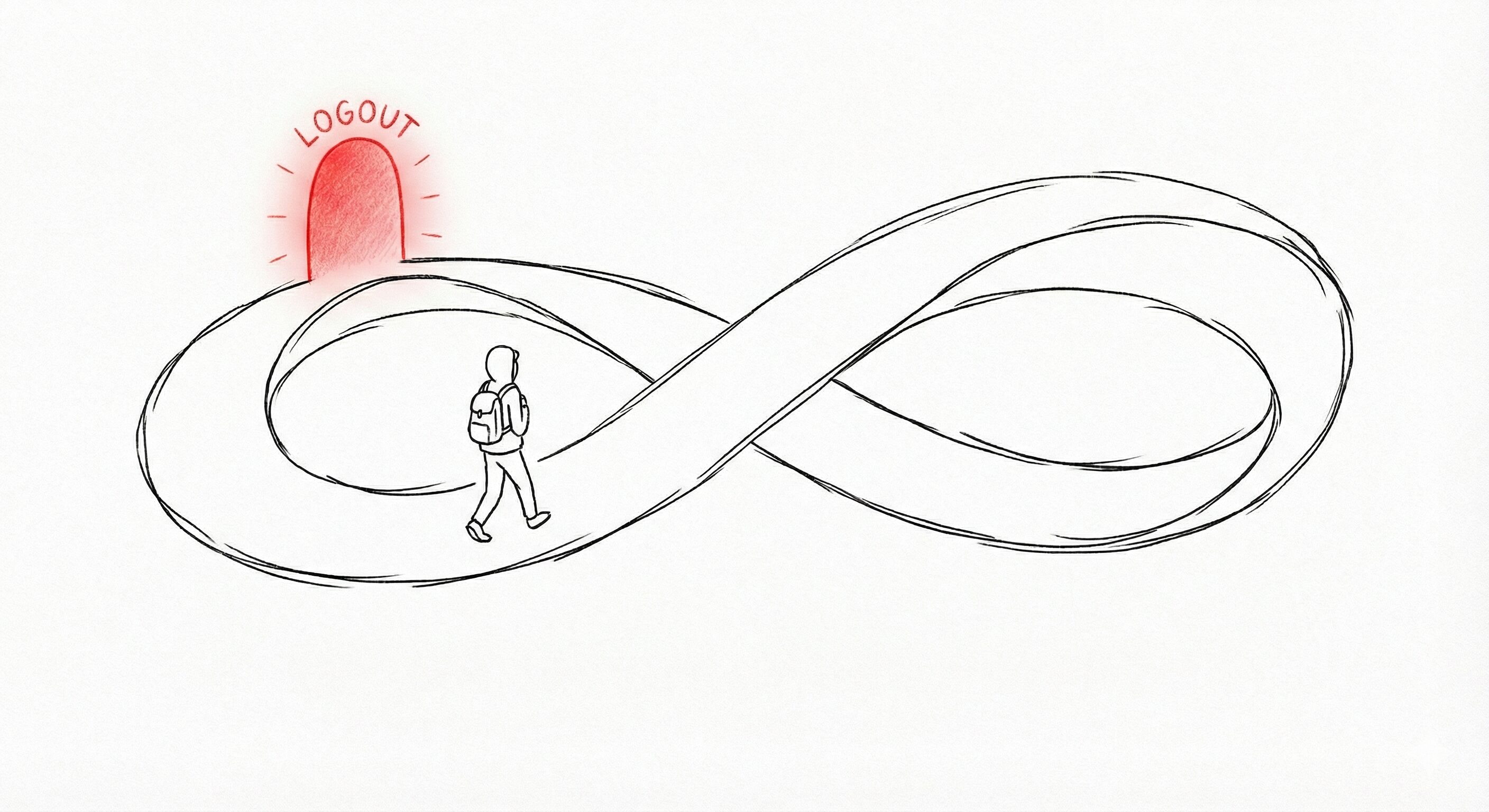

Ich nenne diesen Zustand algorithmische Unausweichlichkeit: die faktische Unmöglichkeit, sich zentralen digitalen Systemen zu entziehen, ohne den Zugang zu Chancen, Beziehungen oder Märkten zu riskieren. Was wie eine Wahl aussieht, ist oft nur die Wahl zwischen Teilnahme und Ausschluss. Genau hier muss Regulierung ansetzen.

Drei Mechanismen, die Opt-out zur Illusion machen

Netzwerkeffekte

Bei Plattformen wie WhatsApp, LinkedIn oder Google Maps ist der eigentliche Wert nicht die Software, sondern das Netzwerk dahinter. Signal mag technisch überlegen sein, aber wenn niemand aus dem eigenen Umfeld dort ist, ist es wertlos. Je mehr Menschen eine Plattform nutzen, desto höher der Nutzen für jeden Einzelnen und desto höher die Kosten des Ausstiegs.

Beispiel LinkedIn: Ein Freelance-Berater in Frankfurt hat über Jahre 2.000 Kontakte aufgebaut, 50 Empfehlungen gesammelt, seine Expertise durch Beiträge dokumentiert. Recruiter finden ihn über die LinkedIn-Suche. Wenn er zu einer Alternative wie Xing wechselt, muss er nicht nur neu anfangen, sondern wird für einen erheblichen Teil des Arbeitsmarkts unsichtbar, weil Headhunter primär auf LinkedIn suchen. Der Netzwerkeffekt bindet ihn nicht durch einen Vertrag, sondern durch die schlichte Tatsache, dass seine beruflichen Beziehungen dort kodifiziert sind.

Beispiel Google Maps: Ein Restaurantbesitzer in Berlin lebt von Laufkundschaft. 80 Prozent seiner Neukunden finden ihn über die Suche nach Restaurants in der Nähe. Seine 340 Bewertungen mit 4,6 Sternen sind sein wichtigstes Marketingkapital. Theoretisch könnte er auf Apple Maps oder OpenStreetMap setzen. Praktisch suchen dort kaum Kunden. Der Ausstieg aus Google Maps ist der Ausstieg aus der lokalen Sichtbarkeit.

Wechselkosten

Digitale Plattformen akkumulieren etwas Wertvolles: verifizierte Reputation. Bewertungen, Transaktionshistorien und Leistungsnachweise sind Kapital, aber Kapital, das beim Wechsel verfällt.

Beispiel Uber. Fatima fährt seit drei Jahren für Uber in Hamburg. Sie hat 4,92 Sterne bei 4.200 Fahrten. Diese Bewertung ist bares Geld, denn der Algorithmus gibt ihr bevorzugt lukrative Flughafenfahrten und Geschäftskunden. Eines Tages senkt Uber die Provision. Fatima ist unzufrieden und prüft den Wechsel zu Bolt. Das Problem: Bei Bolt startet sie bei null. Keine Historie, keine Sterne, keine Bevorzugung. Der Algorithmus behandelt sie wie eine Anfängerin. Ihre 4.200 Fahrten, drei Jahre Arbeit, sind nicht übertragbar. Der Wechsel ist möglich, aber er kostet sie Monate an Einkommenseinbußen, bis sie sich wieder hochgearbeitet hat.

Beispiel Airbnb. Thomas vermietet seit 2016 seine Ferienwohnung am Bodensee. Er ist Superhost mit 280 Fünf-Sterne-Bewertungen. Gäste buchen bei ihm, weil die Bewertungen Vertrauen schaffen. Wenn Airbnb die Gebühren erhöht, kann Thomas theoretisch zu Booking.com oder Vrbo wechseln. Aber seine 280 Bewertungen bleiben bei Airbnb. Bei der Konkurrenz ist er ein Neuling ohne Vertrauensnachweis. Die Plattform hat seine Reputation effektiv monopolisiert, ohne sie formal zu besitzen.

Datenvorsprung

Je mehr Nutzer eine Plattform hat, desto besser werden ihre Algorithmen und desto schwerer wird es für Konkurrenten, aufzuholen.

Beispiel Amazon: Die Produktempfehlungen basieren auf Milliarden von Transaktionen. Ein neuer Online-Marktplatz hat diese Daten nicht. Seine Empfehlungen sind schlechter. Nutzer kaufen weniger. Er bekommt nie die Daten, die er bräuchte, um besser zu werden. Das Ergebnis ist ein sich selbst verstärkender Kreislauf. Der Marktführer wird immer stärker, weil er schon stark ist. Opt-out aus Amazon bedeutet für Verkäufer oft schlechtere Sichtbarkeit, weniger Verkäufe, Existenzgefährdung.

Diese drei Mechanismen wirken zusammen. Sie zeigen das formale Wahlfreiheit nicht ausreicht, um faktischen Zwang zu verhindern. Europa hat die richtigen Begriffe und erste Werkzeuge, aber der entscheidende Schritt ist noch nicht vollzogen.

Drei Lebensbereiche, in denen Opt-out bereits scheitert

Plattformarbeit

Kemal meldet sich bei Lieferando an, weil er flexibel arbeiten möchte. Die App zeigt ihm Aufträge, manche lukrativ, manche nicht. Er lehnt die schlechten ab. Nach einigen Ablehnungen bemerkt er, dass die App ihm immer seltener gute Aufträge zeigt. Der Algorithmus bestraft seine Autonomie durch geringere Sichtbarkeit. Kemal lernt: Echte Wahlfreiheit gibt es nicht. Wer ablehnt, wird unsichtbar.

Die EU hat begonnen, diese Asymmetrie zu adressieren. Aber ohne portierbare Leistungsnachweise bleibt selbst der unzufriedene Fahrer gefangen. Seine drei Jahre Erfahrung bei Lieferando zählen bei Wolt nichts.

Wohnungs- und Kreditmarkt

Anna, 28, Ärztin in Weiterbildung, zieht für eine Stelle nach Köln. Sie bewirbt sich auf Wohnungen. Viele Vermieter verlangen eine SCHUFA-Auskunft. Ihr Score liegt bei 87 Prozent, nicht schlecht, aber auch nicht exzellent, weil sie als Studentin wenig Kredithistorie aufgebaut hat. Große Wohnungsgesellschaften nutzen automatisierte Vorauswahl: Bewerber unter 90 Prozent werden aussortiert, bevor ein Mensch die Unterlagen sieht. Anna bekommt keine Einladungen zur Besichtigung. Sie weiß nicht, warum. Der Algorithmus hat entschieden, ohne Begründung, ohne Einspruchsmöglichkeit.

Der EuGH hat klargestellt, dass solche automatisierten Bewertungen nicht als harmlose Vorstufe behandelt werden dürfen. Die Opt-out-Option, sich der Bonitätsprüfung zu verweigern, existiert theoretisch. Praktisch bedeutet sie den Ausschluss vom Mietmarkt in jeder deutschen Großstadt.

Sichtbarkeit und Reichweite

Lena fertigt handgemachte Keramik und verkauft über Instagram. Sie baut sich 8.000 Follower auf, ihr Kundenstamm. Dann ändert Instagram den Algorithmus. Beiträge werden nur noch zehn Prozent der Follower gezeigt, außer man postet täglich, nutzt Reels und interagiert ständig. Lenas Reichweite bricht ein. Sie hat zwei Optionen: ihr Geschäftsmodell an den Algorithmus anpassen oder Kunden verlieren. Ein Wechsel zu einer anderen Plattform? Ihre 8.000 Follower kann sie nicht mitnehmen. Sie müsste bei null anfangen.

Der Digital Services Act (DSA) verlangt Transparenz über Empfehlungssysteme. Aber Transparenz allein schafft keine Alternativen. Lena versteht jetzt vielleicht, warum ihre Reichweite sinkt, aber sie bleibt gefangen, weil ihr Kundenstamm an die Plattform gebunden ist.

Vier Bausteine für echte Wahlfreiheit

Echte Portabilität

Das Recht auf Datenübertragbarkeit nach Art. 20 DSGVO ist ein Anfang, aber in der Praxis oft wertlos. Wer seine Uber-Daten exportiert, erhält eine Datei mit Fahrten, aber keinen verifizierten Nachweis seiner Bewertung, den eine andere Plattform akzeptieren würde.

Plattformen ab einer bestimmten Größe müssen standardisierte, verifizierte Reputationsnachweise bereitstellen. Das bedeutet, dass Fatimas 4,92 Sterne bei Uber in einem maschinenlesbaren Format exportiert werden, das Bolt importieren und anerkennen muss. Thomas‘ 280 Airbnb-Bewertungen werden kryptographisch signiert, sodass Booking.com sie verifizieren kann. Lenas 8.000 Instagram-Follower erhalten die Möglichkeit, ihr auf eine neue Plattform zu folgen, ohne sich dort neu anmelden zu müssen. Der Digital Markets Act (DMA) enthält Interoperabilitätspflichten für Gatekeeper. Diese müssen auf Reputationsdaten ausgeweitet und mit konkreten technischen Standards versehen werden.

Pflichten für Hochrisiko-Algorithmen

Wenn ein Algorithmus über Kredit, Wohnung oder Arbeitszuteilung mitentscheidet, reicht es nicht, ihm Fairness zu wünschen. Der EU AI Act klassifiziert solche Systeme als Hochrisiko.

Jede automatisierte Entscheidung, die wesentlichen Einfluss auf Lebenschancen hat, muss eine verständliche Begründung enthalten. Anna muss erfahren, dass ihre Bewerbung abgelehnt wurde, weil ihr SCHUFA-Score unter dem Schwellenwert von 90 Prozent liegt, und welche Faktoren dafür verantwortlich waren. Sie muss innerhalb von 48 Stunden Einspruch einlegen können, der innerhalb von 14 Tagen von einem Menschen geprüft wird. Aufsichtsbehörden müssen sektorspezifische Fairness-Standards entwickeln. Welche Faktoren dürfen beim Kredit-Scoring verwendet werden? Welche nicht? Die OECD-Prinzipien liefern den normativen Rahmen.

Compute-Governance für Frontier-KI

Bei den leistungsfähigsten KI-Systemen, Modellen wie GPT-5 oder Gemini 3, verschärft sich das Problem der Unausweichlichkeit. Wer als Unternehmen wettbewerbsfähig bleiben will, muss diese Systeme nutzen. Aber sie sind hochkonzentriert: Drei US-Konzerne kontrollieren den Markt.

Rechenleistung ist der physische Engpass, über den sich Frontier-KI regulieren lässt. Trainingsläufe ab 10²⁵ FLOP sollten vorab bei einer europäischen Behörde registriert werden müssen. Cloud-Provider wie AWS, Google Cloud und Microsoft Azure, die diese Rechenleistung bereitstellen, werden als Intermediäre in die Aufsicht eingebunden. Handelbare Compute-Genehmigungen können Entwicklungstempo mit Sicherheitsanforderungen balancieren.

Anfechtbarkeit als Normalfall

Es geht nicht darum, dass jeder Betroffene den Code liest. Es geht darum, dass Entscheidungen nachvollziehbar, anfechtbar und korrigierbar sind.

Kemal, der Lieferfahrer, dessen Sichtbarkeit sinkt, muss erfahren, dass seine Auftragszuweisung reduziert wurde, weil seine Ablehnungsquote bei 23 Prozent lag. Er muss die Möglichkeit haben, innerhalb von 72 Stunden einen Einspruch einzulegen, der von einem Menschen geprüft wird. Das Europäische Zentrum für Algorithmische Transparenz sollte mit Ressourcen und Befugnissen ausgestattet werden, um Stichprobenprüfungen durchzuführen.

Warum das keine rein europäische Frage ist

Die beste europäische Architektur bleibt wirkungslos, wenn Plattformen und KI-Systeme in anderen Jurisdiktionen entwickelt werden und von dort aus operieren. Algorithmische Unausweichlichkeit ist deshalb auch Außen- und Handelspolitik.

Die EU sollte mit dem ASEAN-Raum und weiteren Indo-Pazifik-Partnern einen Club kompatibler Standards aufbauen. Der ASEAN-Leitfaden für KI-Governance zeigt, dass Interoperabilität und Verantwortlichkeit auch dort Ziele sind. Das bedeutet einheitliche Formate für Reputationsdaten, die in der EU wie in Singapur funktionieren, geteilte Prüfkapazitäten für Hochrisiko-KI und gegenseitige Anerkennung von Zertifizierungen. Die digitalen Partnerschaften der EU bieten den institutionellen Rahmen. Hohe Standards werden dann zum Marktzugangsvorteil statt zum Handelshemmnis.

Schluss

Diese Beispiele zeigen dasselbe Muster. Opt-out existiert auf dem Papier, aber nicht in der Realität. Der Ausstieg ist möglich, aber nur um den Preis von Beziehungen, Einkommen oder Chancen. Das ist die Simulation von Wahlfreiheit.

Aus dieser Analyse ergeben sich fünf Prioritäten. Erstens, Reputationsportabilität gesetzlich verankern: Bewertungen, Transaktionshistorien und Follower müssen in standardisierten Formaten exportierbar und von Konkurrenzplattformen importierbar sein. Zweitens, Begründungspflicht für algorithmische Entscheidungen: Jede Entscheidung mit wesentlichem Einfluss auf Lebenschancen muss die wichtigsten Faktoren nennen, in verständlicher Sprache. Drittens, verbindliche Einspruchsfristen: 48 Stunden für die Eingangsbestätigung, 14 Tage für eine Entscheidung durch einen Menschen. Viertens, Registrierungspflicht für Frontier-KI: Trainingsläufe ab definierter Compute-Schwelle müssen vorab gemeldet werden, mit Cloud-Providern als Compliance-Partnern. Fünftens, internationale Standardclubs: gemeinsame Portabilitätsformate und gegenseitige Anerkennung von KI-Zertifizierungen mit ASEAN und Indo-Pazifik-Partnern.

Die entscheidende Frage ist nicht, ob Menschen theoretisch Nein sagen dürfen. Die entscheidende Frage ist, ob Nein-Sagen realistisch ist, ohne dass es zur Selbstbestrafung wird. Erst wenn Opt-outs praktisch nutzbar sind, lässt sich wieder von freiwilliger Einwilligung sprechen. Dann gehen auch Fortschritt und Freiheit wieder zusammen.

Kontakt

Wollen Sie mit uns in Kontakt treten?

Weitere Information zu uns und wie Sie Ihren Beitrag bei FMP veröffentlichen können, finden Sie hier.